批评研究与统计之所以困难,部分原因在于可提出的批评角度实在太多,这反而让任何单一的批评都显得无关紧要。一条好的批评,其价值在于它是否有可能成为一种「能带来实质性改变的差异」,从而影响我们的最终行动。

摘要

对于科学与统计研究,我们必须秉持批判的眼光去审视,方能判断其论断的可信度。可复现性危机与元科学的崛起已经揭示:大量研究不仅质量堪忧,其结论也往往是错误的。

然而,任何一项研究都可能因无数潜在问题而受到指摘,与那遥不可及的理想相去甚远。这使得我们难以分辨何种批评至关重要,而这些批评又可能沦为纯粹的空谈。我们该如何从纷繁的意见中,甄别出致命的缺陷、善意的提醒和无谓的指摘?

为此,我提出一个务实的标准:一项批评之所以重要,关键在于若加以修正,它能在多大程度上改变研究结果,以及这一改变又将在多大程度上影响我们的决策或行动。简言之,它是否构成了「一个足以带来改变的差异」。

这便是为何研究造假、因果推断谬误,或那些导致结果被严重高估的偏见,都具有普遍的重要性——因为一个所谓的「因果」效应,如果真相是毫无效果或被极大夸大,那几乎所有基于该研究的决策都将被颠覆。与此相对,其他同样常见的问题,如测量误差或分布假设,通常并不那么重要,因为它们对结论的改变甚微,进而对决策的影响也微乎其微。

如果我们能时常反思一项批评是否会带来如此根本性的改变,那么我们就能更清晰地分辨,哪些是切中要害的批评,而哪些只是夸夸其谈,反而阻碍了对研究的有效评估。

学习统计学无疑是件好事。如果你想广泛阅读并理解科学论文,那没有什么比学习统计学更有效的了。因为当今世界,万事万物都与统计问题息息相关,并依赖于日渐强大的统计方法和海量数据集——上至机器学习这类光鲜前沿的领域,下至遗传学家挖掘数百万人的生物样本库这类基础工作。若你对统计学缺乏基本了解,你将日益被科学技术的浪潮抛在身后,无法就其社会应用展开有意义的讨论。因此,只要你对这些话题稍有兴趣,就必须打下坚实的统计学基础——我本想这样断言。但问题在于……学习统计学可能暗藏风险。

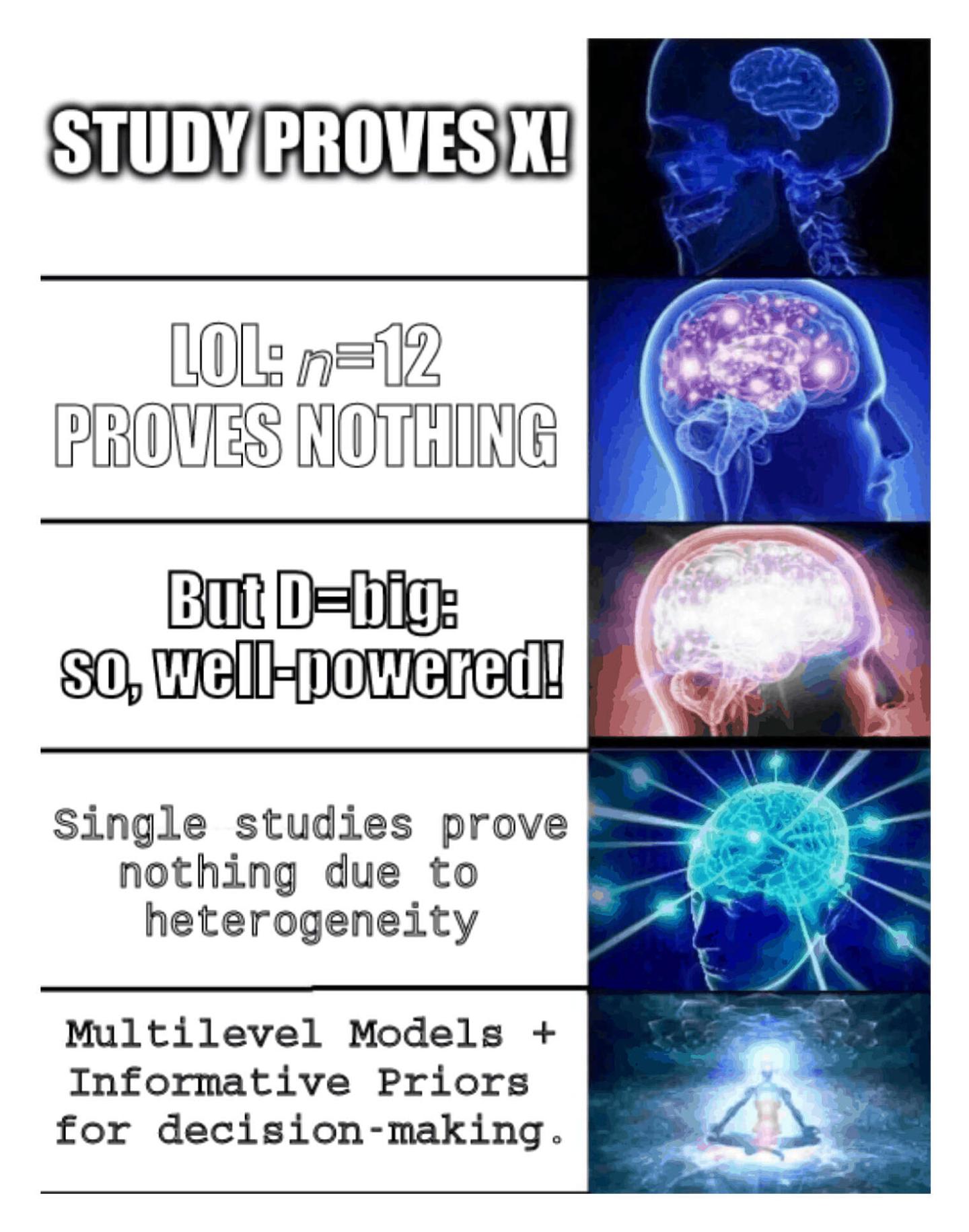

1 统计学的「谬误之谷」

学习统计学,就像初涉形式逻辑或认知偏见理论,恰如亚历山大·蒲柏所言:「一知半解,乃是危途 / 皮埃里亚清泉,宜当深饮,不宜浅尝 / 浅尝辄令头脑发昏,/ 痛饮方使神智清醒。」

当你初学形式逻辑和谬误理论时,便会迫不及待地挥舞这把崭新的锤子,到处玩「谬误对对碰」的游戏(恕我在此混合使用隐喻):「哈!先生,您这犯了人身攻击的谬误,此乃逻辑上不成立的反驳。」然而问题在于,许多所谓的「谬误」在归纳逻辑中完全站得住脚:例如,人身攻击往往与议题高度相关(比如当事人受贿)。若一味固守形式逻辑的藩篱,充其量是浪费时间,最坏的情况则是沦为一种工具,通过选择性地运用严谨规则来自欺欺人。

同样,认知偏见理论虽易于滥用,却难以善用(因为在某些情境下,偏见或许是颇具价值的先验判断;而在那些常见的有害情境中,我们通常早已习得更佳的应对之道)。我们总是能轻而易举地发现,别人是多么可悲地陷入了确认偏见的泥潭。

1.1 包罗万象,巨细无遗

在统计学领域,稍加阅读和自学,你很快就会发现一项研究在统计学上可能出错的万千方式。正如 Ioannidis、Gelman 等学者、可复现性危机以及无数科学发现彻底崩塌的案例所揭示的那样,无论你变得多么富有怀疑精神,可能都还远远不够,因为现实中充斥着大量漏洞百出的研究。以下便是一些潜在的问题,此处不分主次,随意罗列:

- 数据处理(如使用比率/百分比数据,或对同一时间序列进行标准化)导致的「伪相关」。

- 多重性问题:检验了诸多子群组或假设,却只报告统计上显著的结果,未对整体的假阳性率进行控制。

- 未对缺失数据进行建模。

- 将动物体内实验的结果直接套用于人类。

- 实验对象为普通儿童,而非同卵双胞胎。

- 在元分析中检测到发表偏倚。

- 将未能拒绝原假设或一个正向的点估计值,解读为支持原假设的证据。

- 「统计上显著与统计上不显著之间的差异,本身并非统计上显著。」

- 选择了不恰当的概率分布,例如用正态分布去拟合一个对数正态分布的变量(「他们滤掉了先验这只蠓虫,却吞下了似然这头骆驼」)。

- 未使用单盲、双盲或安慰剂对照。

- 某遗传学研究仅检验了 1 个基因与 1 个性状之间的相关性。

- 某智商实验发现,干预措施提升了某些智商分测验的前后测分数,便声称提升了整体智商。

- 采用了横断面研究,而非纵向研究。

- 忽略了多层级结构(例如,数据源自学校、国家、家庭、公司、网站、单个渔船、维基百科编辑等不同层级的子单位)。

- 在报告「全基因组关联研究(GWAS)」多基因分数的表现时,仅使用了达到全基因组统计显著性水平的单核苷酸多态性(SNP)位点。

- 存在样本流失,却未使用意向性治疗分析。

- 使用固定的 α 阈值,如 0.05。

- 将相关性数据解读为因果关系。

- 使用了「不可识别」模型,需要施加额外的约束或先验条件。

- 在审视数据后进行未经预注册的分析;花样百出的p值操纵。

- 使用特定原因死亡率而非全因死亡率作为衡量指标。

- 采用了测量误差极大的测量工具(如膳食调查问卷)。

- 天花板/地板效应(尤其见于智商测试)。

- 基于质量参差不齐的测量数据,对潜在变量下结论。

- 或在「控制」了中间变量后,将一个变量的总效应与另一个变量的纯间接效应进行比较。

- 或声称某个变量介导了某种效应,却并未实际构建一个中介效应的结构方程模型(SEM)。

- 研究的统计功效严重不足,难以检测出合理的效应。

- 「统计显著性过滤器」导致效应量被夸大。

- 基率谬误。

- 自愿参与的调查对象;来自亚马逊土耳其机器人(Mechanical Turk)、谷歌问卷(Google Surveys)或类似服务的便利样本。

- 动物实验的随机化过程未按窝/笼/室进行区组划分。

- 使用一个大型数据集,得出了大量统计上显著的结果。

- 进行了因子分析,却未确立测量不变性。

- 实验者期望效应。

- 使用支持向量机(SVM)/神经网络(NN)/随机森林(RF)等模型,却未进行交叉验证或使用留出样本。

- 使用了上述模型,但数据预处理或超参数选择是基于整个数据集进行的。

- 采用了被动对照组。

- 未进行析因实验,而是在每个组上仅测试一种干预措施。

- 使用无信息先验(flat priors)导致效应量被高估。

- 只报告相对风险增加,却不报告绝对风险增加。

- 某遗传学研究检验了 500,000 个基因与 1 个性状之间的相关性。

- 研究人员或资助方存在利益冲突。

- 实验设计缺乏功效分析。

- 将李克特量表(Likert scales)当作简单的连续等距变量进行分析。

- 动物实验仅在单一近交或克隆品系中进行,以期减少变异/提升功效(Michie 1955)。

- 数据存在右删失。

- 测量值存在时间自相关。

- 遗传混杂因素。

- 过度依赖交互项。

以上问题,有些是致命的,一旦出现,研究便毫无价值,甚至可以说,若这些研究人员从未发表过文章,世界反倒会更美好。另一些问题虽也严重,但尚可容忍,受其困扰的研究仍有其参考价值,或许已是当前条件下所能做到的极致。还有一些则通常是细枝末节,几乎无关大局,若将它们当作「批评」提出,反而可能误导他人,暗示这些小瑕疵值得商榷。更多的,则完全取决于具体情境,其影响可能天差地别,从瞬间致命到微不足道。

但究竟该如何区分呢?你或许能猜到其中几项的严重程度,但若说你对我所列的每一项都了然于心,并能就其重要性给出充分的论证,那我倒要感到惊讶了,因为连我自己都做不到,而且我怀疑世上鲜有人能做到。更无人能告诉你每一项到底有多重要。我们似乎只能凭经验摸索,年复一年地观察各种发现在元分析中被成功复现或效应减弱,抑或被彻底推翻,从而逐渐培养出对问题重要性的直觉。诚然,市面上有不少核查清单和专业手册checklists可供参阅,它们至少具备清单的优点——能系统性地提醒我们该检查哪些方面,减少我们凭主观偏好选择性批判的冲动。我推荐使用这些工具,但它们并非万全之策。(在某些情况下,它们甚至会推荐一些相当糟糕的做法,而且没有一份清单称得上是完备的。)

无怪乎统计批评有时让人感觉像一场残酷的肉搏,又好似在学习统计显著性检验:面对一长串缺乏内在逻辑的特例检验,拼凑出一本满是武断公式和仪式的「食谱」,其主要功用,不过是为了进行「中产阶级式的轻蔑」。

久而久之,你学到的东西足以让你对任何研究抛出一连串的批评,无论其是否切题,从而进行所谓的「伪分析」Jackson。这种做法贬低了批评的价值(毕竟,不可能所有研究都同样一文不值),并带来了与滥用形式逻辑或认知偏见理论同样的风险——最终只是将知识武器化,费尽心机却让自己错得更加离谱,并学会用更精巧的言辞来捍卫自己的谬误。(多年来,我曾批评过许多研究。尽管我对其中不少研究的批评,其尖锐程度远不及它们本应受到的审判,且事后也证明我的观点是对的,但我无法诚实地宣称自己总是正确,或从未有过偶尔的夸大其词、画蛇添足。)

2 中肯却非定论

那么,我们所说的统计批评,其内涵究竟是什么?何种统计异议称得上是良策,何种又算作劣评?

2.1 坏的批评

在此,我想说:一个轮子,即便能转动,但若不能带动其他任何部件,那它就不是这套机械的一部分。

——路德维希·维特根斯坦,§271,《哲学研究》

一项批评的好坏,绝不能仅凭其是否乏味、是否让人不屑一顾来判断。试想在 2000 至 2010 年间,若有人在每次遗传学讨论中都反复叨念统计功效与多基因性,宣称所有那些激动人心的新候选基因和基因-环境交互作用的研究结果都是一派胡言,整个文献领域都是垃圾——此人言论想必令人极度不快,很快就会让人心生厌烦,但他的观点却被证明是完全正确的。(同样的情况也适用于营养学研究、社会心理学研究,等等……)尽管听着又一个人高喊「相关不等于因果」或「呵,那是在老鼠身上!」,或许会让人觉得聒噪,但不幸的是,对于许多研究而言,这便是对其唯一应该做出的评价,无论我们听得多么腻烦。

一项批评的好坏,也不能仅仅因为它指出了某个假设被违背(或未经证实、无法证实),或现实世界的某个方面被模型忽略。因为所有的统计模型本质上都是高度抽象、极其粗略的简化。我们永远可以从任何分析中挑出毛病:正态性假设不当、某段自相关未被建模、某个非线性项被遗漏、某些先验信息未被采纳,或是数据在某方面存在缺失。清单、预注册等方法固然能显著提升研究质量,却永远无法根除这一问题。除非是对计算机模拟进行同义反复式的分析,否则完美无瑕的统计分析既不曾存在,也永远不会存在。即便存在,它也会复杂到无人能懂(这本身也是一种批评)。我们所有的模型都是错的,但其中一些或许有用,而一项好的统计分析,仅仅是「足够好」而已。

一项批评的好坏,同样不能取决于结果是否「可复现」。可复现性所能告诉我们的,无非是若用同样方法收集更多数据,结果将保持不变。一个无法复现的结果,其价值充其量是存疑的(它很可能从一开始就是虚假的^[一个无法复现的结果,会将原始研究置于一个尴尬的三难困境中:要么原始结果是伪结果(这是先验上最可能的情况);要么复现者操作失误或运气不佳(但这很难成立,因为多数复现研究的功效充足且遵循了原始方案,所以——汝之肯定前件,即吾之否定后件——反倒更容易论证是原始研究运气不佳);要么该研究的论断本身极其脆弱且高度依赖特定情境,以致于无法复现只是所谓的「异质性」(但若是如此,当一个结果在别处是否存在都如同抛硬币一般,又怎能指望任何人对其抱有实质性的信任,或据此采取行动呢?)。]),而一个可复现的结果,也绝非质量的保证。你或许拥有一套稳定产出「无用输入,无用输出(GIGO)」的流程,但可复现的垃圾依然是垃圾。收集更多数据,可能仅仅意味着更精确地估算出了流程中的系统误差和偏见而已。(无论你能找出多少篇已发表的论文声称顺势疗法有效,它就是无效的。)

当然,这也与 p 值基本无关,无论是在单项研究中还是在其复现研究中(因为任何有价值的东西都与 p 值无关)。如果我们修正一个错误,使一个具体的 p 值从 p=0.05 变成了 p=0.06,又能如何?(「想必上帝垂爱 0.06 的程度,并不会比 0.05 逊色多少……」)后验概率虽有其意义和重要性,但同样不能作为评判标准:一项研究中,某个参数大于零的后验概率是 95% 而非 94%,这很重要吗?大于 99% 呢?大于 50% 呢?如果一项批评在修正后,将后验概率从 99% 降至 90%,这便是我们所说的重要批评吗?恐怕(咳)未必。

它也与效应量的增减无关。如果一项研究因某些错误,使其报告的效应量是应有值的两倍,这或许是致命的缺陷,也可能无关痛痒。也许原本的不确定性就很大,以至于没人会把点估计值当真;又或者,人人都明白存在错误的可能,并视其点估计值为一个上限。再或者,这个效应本身是如此巨大,即便是高估了 10 倍也无伤大雅。

它通常也与预测能力无关(不论是用 R² 还是 AUC 等指标来量化)。纯粹的预测只是研究中一小部分的目标(当然,如果有人能证明某个特定选择导致了更低的预测分数,那会是一项有力的批评)。在许多情况下,最好的模型预测能力并不突出,而一个模型预测能力过强,反倒是一个危险信号。

2.2 好的批评

统计学家已不再是人们期望能从一堆废料中炼出黄金的炼金术士。他更像一位化学家,能够精确评鉴原料的价值几何,并从中提取出等量的价值,分毫不差。如此一来,若因其结果精确而赞誉,或因其不精确而指摘,都是愚蠢的。倘若他技艺精湛,其结果的价值便完全取决于所用材料的价值。材料中包含多少信息,他便提取多少,仅此而已。他的职责,不过是呈现材料之所含……在劣质数据上进行极其繁重的计算,或许能将产出率从 95% 提升至 100%——这 5% 的增益,对于微不足道的总量而言,可能无甚意义。而对数据收集流程或实验设计进行一次专业的审视和革新,往往能以同等的时间和人力成本,将产出率提升十倍乃至十二倍。

……实验尘埃落定之后再请教统计学家,往往无异于请他来做一次事后验尸。他或许能告诉你,这场实验的死因。

——R. A. Fisher,「在第一次印度统计大会上的主席致辞」,1938 年

那么,何种批评才称得上是好的批评?

譬如,若一份研究草稿显示,其论断基于某个变量的统计显著效应,但最终发表的版本却对该变量避而不谈,转而讨论另一个不同的变量,这便引人深思。若发现某研究的作者们从研究结果的受益公司处收取了数百万美元,人们对该结果的信心便会大打折扣。若某项相关性在同一家庭的兄弟姐妹间、甚至在同卵双胞胎间进行比较时便荡然无存,或是在其他数据集、其他国家中并不存在,那么无论它在单一数据集中显得多么稳固,都足以令人警惕。若一个花哨的新机器学习模型号称性能比当前最优(SOTA)模型高出 2%,结果却被发现未能正确使用留出样本,实际表现并无差异,机器学习研究者们的热情无疑会大减。若有人证明一项随机对照试验(RCT)得出的效应方向与相关性分析的结果截然相反,大多数人都会认为这是个重大问题。若一种新型抗癌药物在最新试验中被吹捧为与常规化疗同样有效且副作用更少,但人们发现,两者的疗效都是与「零效应」的原假设进行比较,且新药的点估计值低于常规化疗,患者们还会愿意使用它吗?若一项心理学实验在使用被动对照组与主动对照组时得出不同结果,或一项外科手术的成败取决于临床试验是否采用盲法,这显然是个问题。而如果数据完全是捏造的,那当然更值得揭露。

依据前述的某些传统标准,这些批评的性质可谓天差地别。那么,究竟是什么共同点,使它们都成为了好的批评?

3 信念指引行动

结果的价值,仅在于其与真相的可能差异,对于实验目的而言已小到无足轻重。至于风险与回报的权衡,则取决于:

1. 实验本身的性质所能允许的精确度,

2. 以及所涉议题的利害关系之轻重。

——斯튜登特,1904 年^[引自皮尔逊 1939 年]

此外,经济学的视角(若非因贵族或清教徒式的禁忌而被摒弃)似乎是唯一能清晰辨别不确定性逻辑(即概率论)中何为矛盾、何为自洽的工具。这正是瓦尔德的「可采纳性」概念所给予我们的根本启示……概率论与决策论,不过是研究同一主题——不确定性——的两种表述(理论与实践)而已。

——布鲁诺·德·菲内蒂,「对萨维奇<重读R. A. 费雪>一文的评论」,1976 年

但我认为,所有这些好的批评,其共通之处在于一个决策论的基石,它不仅统一了所有批评(也同样能统一统计学教学法):

一项统计批评的重要性,取决于它在多大程度上可能改变基于该研究的决策。

我坚信,p 值不是后验概率,后验概率不是效应量,效应量不是效用,效用不是利润,利润更不是决策。泾渭分明的判断源于决策。归根结底,一切分析都是决策分析:我们的信念与分析可以是连续变化的,但我们的行动却是离散抉择的。

当我们评判一项研究时,我们所摸索探求的标准,最终必然落脚于现实世界的行动与决策。这个标准本质上是情境依赖的,不容许任何一刀切的界线,并取决于研究的用途与动机,其根基在于何为正确的行事之道。^[有趣的是,「概率」一词的中世纪起源本身就内蕴着决策的考量,其核心问题是:相信什么、依据什么行动,才是合乎道德的。而概率论的数学根源同样务实,源于赌博。当然,拉普拉斯在他早期的贝叶斯主义中也持有类似观点(例如拉普拉斯论证人证言或估算土星质量)。直到后来,如布尔或费雪等统计思想家,才试图摒弃这种务实的解释,转而寻求如极限频率这类更纯粹的定义。]

一个好的批评,与结果是否达到某个武断的「显著性」水平无关,与研究是否「功效充足」无关,与元分析中估算异质性所需的特定 k 值无关,甚至与任何特定的后验概率或效应量阈值都无关。它也与是否违背某个特定假设无关,除非违背该假设导致模型不再「够用」,从而引向错误的选择。它与可复现性有松散的关联(因为一个结果若在未来需要采取行动的情境中无法复现,那它对规划便毫无用处),但并不由其定义(因为一个结果完全可能稳定复现,却依然毫无价值)。

要理解诸多批评的重要性,只需扪心自问:这项研究究竟意在为何?它将如何影响后续的决策?这样一来,许多问题便豁然开朗。我们不必非得走完一套从原始数据、贝叶斯分析,到效用函数、因果模型的完整决策分析流程(尽管这样做大有裨益,在某些极端情况下甚至是必要的)。通常,非正式的思量便是一个很好的起点,因为我们凭直觉就能预见到它对后续决策的影响。

我认为,即便面对那些应用前景尚不明朗的「纯」研究,我们也能有效地运用这一标准。关于认识论、科学方法论,以及何种实践能通往可靠知识,我们已积累了丰富的认知。(当人们以数论催生密码学为例,为纯研究的历史贡献辩护时,这一论证本身就暗示了其衍生应用并非那么不可预测,这恰恰是一种成功的务实辩护!我们演化出的好奇心卓有成效,这绝非偶然。)

例如,即便我们不为某项研究预设特定目的,也能明白为何伪造数据是最恶劣的行径:因为没有任何决策能因采纳伪造数据而变得更好。正如费曼所言:「一项成功的技术,必须让现实凌驾于公关之上,因为自然无法被愚弄。」 许多假设或捷径在某些情境下或能奏效,但与现实脱节的伪造数据,却无一例外地只会坏事。即便伪造的数据被处心积虑地设计,以求精准复刻我们对现实的最佳理解^[这种情况通常不会发生,这也是为何像 Diederik Stapel 这样的造假者,会因其「好到不真实」的结果、过度取整或过于平滑的数据,甚至有时仅仅是算术错误而被识破!(Stroebe 2019 顺便指出,虽然 Stapel 的单个效应在其他研究者看来似乎可信,但整合来看,其效应量大得离谱,在元分析中便显现出异常——源自欧洲而非美国的启动效应研究,其平均效应竟大得蹊跷。) ],它也会因夸大证据强度而损害决策,导致过度自信和探索不足。

粗心的数据收集和测量误差亦是同理。在通过比对 DNA 数据库中的奇怪条目偶然发现 CRISPR 之前,微生物学家们对此一无所知。这正是纯研究能带来巨大突破的绝佳例证。但试问,如果 DNA 数据库残缺不全、充斥着错误标记或被污染的样本,抑或测序过程草率马虎,序列数据纯属一堆随机垃圾,你又如何能从中发现任何东西?如果你研究的是「癌细胞」,结果它们却是被贴错标签的肝细胞系,这又如何能增进我们对癌症的认知?

再来思考安慰剂效应。如果你得知某项研究的结果完全由安慰剂效应驱动,一旦采用盲法,效应便会消失,我可以断言——无论涉及何种领域、何种主题——你几乎总会大失所望。如果一项研究仅仅测量了安慰剂效应(具体而言,是实验者期望或受试者预期效应),这是毁灭性的打击。因为我们早已知道安慰剂效应普遍存在(因此再次证明它并无新意),其作用机制是狭隘的心理通路,会随时间消退,且不影响死亡率等硬性终点。然而,它却并未作用于那些被安慰剂偏倚的研究表面上似乎正在操纵的无数因果机制(而对这些机制的操纵,本可对即时应用和理论构建大有裨益)。举例而言,如果心脏支架除了通过安慰剂效应外,并不能真正缓解胸痛,我们为何还要使用它?诚然,在某些情况下,得知结果仅为安慰剂效应后我们或许无动于衷(例如慢性疼痛治疗?或轻度流感?),但这样的例外寥寥无几。

那么不可复现性呢?对心理学「可复现性危机」最简单的解释是:大多数已发表的结果并非真实存在,不过是随机噪音被通过 p 值操纵的伎俩发表出来罢了。而辩护者们给出的最善意的解读则是:这些效应确曾真实,但它们要么效应量微小,要么高度依赖于具体情境的精确细节(如实验地点、问卷纸张颜色、实验员等),以至于即便与原作者合作,也无法保证复现。这再次构成了一个三难困境,从决策论的视角看,其破坏性尤为巨大:

- 要么结果是虚假的(对决策毫无用处);

- 要么效应量远小于报告值(因此在任何应用或理论构建中都大打折扣);

- 要么效应极其脆弱,在任何未来的情境中,几乎同样可能呈现为其他效应,甚至方向相反,导致其平均效应趋近于零(因此毫无用处)。

决策先于信念。我们的本体论与认识论,源于我们的决策理论,而非相反。这在逻辑上看似本末倒置,但作为在不确定性中思考与行动的、演化而来的具身存在,这便是我们的处境:我们就像奥托·纽拉特所比喻的木筏上的水手——我们无法「抽身而出」,从零开始,基于逻辑形而上学构建全部的信念与知识。相反,我们只能立足于木筏之上,一片片地检查并修复它。对于怀疑论者(如普兰丁格),自然主义的回应是:我们的信念并非因其源于经验、演化或试错而不可靠;恰恰相反,它们之所以可靠,正是因为它们在演化中被逐步塑造,以求在实践中做出正确的决策。并且,受演化法则的约束,我们发展出了关于世界的可靠知识和科学方法。(多伊奇-华莱士试图将量子力学多世界诠释中的玻恩定则建立在决策理论之上,便是这种逻辑倒转的一个范例。更早之前,如斯튜登特、弗兰克·P·拉姆齐、亚伯拉罕·瓦尔德、伦纳德·J·萨维奇、霍华德·雷法与罗伯特·施莱弗等统计学家已经证明,大部分统计学可以奠基于决策,而非相反。主观概率学派,以及诸如荷兰赌这类强制一致性的工具,都为此提供了明证。)

3.1 基于决策论的批评

决策分析的威力,更多地体现在其威慑力,而非执行本身。

——安德鲁·盖尔曼,2019 年

一个不错的经验法则是:「如果我给这个数字末尾加个零,含有它的这个句子对我的意义会有所不同吗?」如果答案是「否」,那么这个数字或许从一开始就不该出现在句子里。

——兰德尔·门罗

现在,让我们用决策论的视角,重新审视一些之前提到的批评:

- 批评将相关等同于因果是一项切中要害的批评。因为相关通常不等于因果,将对因果关系的信心从一个想当然的 ~100%,降至一个更现实的 25% 甚至更低,将会改变许多决策。仅此一项认知,便足以将一项措施的预期价值削减超过 75%,如此巨大的减损足以淘汰掉许多听起来颇具吸引力的选项。

由于因果效应是研究的核心议题,任何影响相关性推断(而非因果推断)的方法论谬误,都是重大谬误。 - 批评分布假设(例如,指出某个变量更符合学生 t 分布而非正态分布)通常并非一项重要批评。因为这种调整对任何关键变量后验分布的改变都微乎其微,仅仅可能影响那些本就模棱两可、悬于一线的决策(因此,这些决策本身的价值也有限)。

- 但凡事皆有例外,在某些领域,分布假设可能至关重要。例如,用正态分布替代对数正态分布通常影响不大,因其在分布的主体部分非常相似……除非我们讨论的是它们的尾部。在次序统计量的应用场景中(如人事选拔、竞技体育、媒体传播、自然灾害,或人才流失模型等涉及极端值的分析),尾部的极端值才是关键。此时,若误用正态分布,将导致严重低估极端离群值的出现概率,这在实践中可能造成严重后果。

- 另一方面,将李克特量表(Likert scale)视为等距变量,在统计学上是一桩罪过……但这不过是个人人都会犯的、无伤大雅的小瑕疵。因为李克特量表的表现往往等同于一个(噪音更大的)正态分布变量,以至于费尽心力将其正确地转换为带潜在变量的序数模型,结果往往是事倍功半,并不会真正改变任何结论,也便不会改变任何行动。^[尽管这在理论上不正确,但每当我费力地按标准流程处理序数变量时,结果通常只是微调了系数和标准误,并未真正改变任何实质性结论。鉴于此,若无特殊理由(例如我重新分析数据并——破天荒地——得出了截然不同的结果),而去批评他人同样的做法,便是不诚实的。]

同理,时间自相关问题的重要性,也常常被夸大。 - 受遗传因素混淆的社会学/心理学相关性研究极易受到攻击。因为一旦控制了遗传因素,相关性往往会大幅缩小,甚至降至零,从而使绝大多数基于此的因果推断化为泡影。

- 对训练集过拟合,导致实际表现与当前最优(SOTA)模型相当甚至更差,这是机器学习领域最严重的批评之一。因为追求更优的性能,通常是人们采用一个新方法的根本原因。(当然,凡事无绝对——如果新方法构思巧妙,或具备其他实践优势,那么对于某些使用者而言,性能上的些许损失是次要的,他们看重的是其他优点。此时,声称过拟合只是小问题,也完全合情合理。)

- 使用稻草人式的原假设:在医学领域,关键在于评估新疗法相较于当前最佳疗法的成本效益,而非它是否比「什么都不做」要好。决策的核心是,新方案是否比默认方案更具成本效益,从而促使人们选择它。如果综合评估下来,新疗法可能还稍逊一筹,人们又为何要选择它呢?

- 将未能拒绝原假设,解读为原假设成立的证据:这是一个常见的问题。显著性检验的逻辑(如果它也算逻辑的话)要求,只要未能拒绝原假设,我们就应保持不可知。但贝叶斯式的推理——没有证据即是反对的证据——是如此符合直觉,以至于当一项检验未能支持某个假说时,我们便自然地将其解读为反对该假说的证据。然而,这很可能恰恰是支持该假说的证据,只是证据尚不充分而已。因此,一个理性的人很可能得出与直观解读截然相反的结论。

这让我想起那些关于弓形虫的研究。研究者用小样本来估算弓形虫感染与事故发生率等指标的相关性,得出的点估计值与其他大规模研究的结果(即感染预示着负面后果)几乎一致,但由于样本量小,结果未达统计显著性。于是他们便断言,自己找到了反对该相关性存在的证据。而实际上,我们应得出截然相反的结论!(一个解读研究结果的经验法则是自问:「如果我将此结果纳入一项包含所有相关研究的元分析,它会增强还是削弱元分析的整体结果?」) - 低效的实验设计,例如采用被试间设计而非被试内设计,或在双胞胎研究中未使用同卵双胞胎,可能具有重大的实践意义。正如斯튜登特在讨论拉纳克郡牛奶实验时指出的,该实验除了其他问题外,采用了未经任何匹配或区组设计的随机儿童样本,导致统计功效被不必要地拉低。如果设计得当,该实验本可以用缩减 97% 的样本量完成,这将节省巨额开支(省下的钱足以资助更多其他实验)。

- 缺乏测量不变性:在智商实验中,「测量不变性」听起来或许深奥难懂,像是统计学上的吹毛求疵,但它归根结底是在问:测试分数的提升,究竟是整体智力的提升,还是仅仅反映了在某个特定分测验(如英语词汇)上的技巧精进?整体智力的提升,其价值远非特定测试技巧的改进可比;如果是后者,那么实验发现的因果效应,不过是镜花水月,虚有其表。

- 混淆测量变量与潜在变量:在讨论潜在变量的测量时,问题的关键往往取决于用途。

一个例子是分析 SAT 分数与大学绩点(GPA)的相关性。你的身份是研究个体差异的心理学家,还是大学招生办的负责人?前者或许希望尽可能地校正测量误差,以探究深层的心理构造;而后者则是在履行职责,必须基于申请学生实际的、未经校正的原始分数来做决策,而不是那些他们希望得到但永远无法获知的、假设的真实分数。

再假设,有人将一个信度较低的智商测试与一个信度很高的人格测试进行比较(且未对二者不同的测量误差进行校正),发现后者更能预测某项生活成就。这是否意味着,对于该成就而言,「人格比智力更重要」?这同样取决于用途。如果你的目的是进行关于潜在变量的理论探讨,这便是一个严重的谬误,校正测量误差后,结论可能完全反转。但如果你的研究服务于人才筛选(如在工业与组织心理学中),那么哪个潜在变量的预测力更强就无关紧要了,因为你只能使用现有的测试工具——然而,从更深一层来看,如果你正在考虑是否要引入一款更精准但更昂贵的智商测试,那么潜在变量的重要性就又凸显出来了。因为,更好的测试所能带来的潜在收益,是否足以证明其高昂的成本,恰恰取决于潜在变量(而非粗糙的测量变量)的真实重要性。

再以遗传力估计为例,比如通过 GCTA 得出的SNP遗传力估计。对某项测量指标,若 GCTA 估计其遗传力为25%,这可以被解读为基于同样测量指标的「全基因组关联研究(GWAS)」所能解释方差的上限。这很有用,但这并不等同于对那个真实的、无测量误差的潜在变量进行 GWAS 的上限,也不同于其广义上的「遗传影响」。大多数 GCTA 研究采用的测量工具都存在巨大的测量误差。如果校正了这些误差,真实的 GCTA 估计值可能会高得多——例如,智商的 GCTA 估计值通常在 25% 左右,但多数研究为了样本量而牺牲了测试质量;若加以校正,真实的 GCTA 估计值将接近 50%,这便是一个截然不同的图景。那么,哪个数字才是「对」的?这取决于你的目的。如果你只是想了解,基于当前这个特定数据集,GWAS的效果天花板在哪里,你的统计功效如何,那么前者是正确的解释。但如果你试图对某个特质本身下结论(正如许多人所做的那样!),那么潜在变量才是关键,只谈论测量变量会产生严重误导,甚至导致完全错误的结论(尤其是在比较那些测量误差水平不同的数据集时)。 - 缺乏盲法也构成类似问题:它的缺席意味着我们所估计的效应,未必是我们真正关心的那个效应——但这同样取决于情境。心理学研究通常采用那些受主观努力程度影响的测量指标,且其研究的效应通常很小(例如双重 n-back 任务号称能提升几点智商),因此受试者稍加努力便可能夸大结果。相比之下,一项抗癌药物的临床试验,若以全因死亡率为指标,其疗效可能在生存率上产生巨大差异。癌细胞可不在乎病人是否乐观,而研究者也很难在全因死亡率这种硬性指标上巧妙地动手脚(因为病人要么活着,要么死了)。

这套定义并非万灵药,因为在很多时候,我们既不清楚研究会影响哪些后续决策,更难以量化一项批评会对这些决策产生多大影响。但它提供了一个清晰的起点,帮助我们辨别哪些批评是(或应该是)重要的(在这一点上,元分析对于确定特定缺陷导致的平均效应偏差等问题尤其有用),而哪些则值得怀疑、纯属吹毛求疵,表明你是在绞尽脑汁地找茬。如果你无法至少有理有据地解释,一项(或一组)批评何以可能导致截然相反的结论或行动,那么,这些批评或许最好还是不说为妙。

4 外部链接

略

5 附录

略

6 脚注

[checklists]据我所知,主要有两大类:汇报清单与质量评估清单(此外,还有各专业团体发布的指南/建议,例如美国心理学会(APA)基于 JARS 制定的手册,或美国教育研究协会(AERA)的标准)。

一些汇报清单:

- STROBE(清单;阐释),用于队列研究、病例对照研究和横断面研究。

- TREND(清单;阐释),用于非随机实验。

- CONSORT(清单;阐释),用于随机对照试验(RCTs)。

- QUOROM/PRISMA(清单;阐释),用于综述和元分析。

一些质量评估量表:

[Jackson]正如杰克逊在一篇针对类似著作的评论中指出的,那些用于反驳遗传力或智商的论证,恰恰是糟糕研究批评的范例,它们将完美当作「更好」的敌人,并选择性地要求严谨:

毫无疑问,在此领域,如同许多依赖实地研究的领域一样,对外部变量的精确控制远未达到完美。例如,在对分开抚养的双胞胎的研究中,研究者必须承认,将双胞胎随机分配到不同寄养家庭的理想状态难以完全实现,找到在所有变量上都完美匹配的比较组或控制组也十分困难。若非要完全摒弃社会科学中的实地数据,我们别无选择,只能采取一种变通的方法,在权衡那些公认有瑕疵的数据中,通过优势证据来寻求对假说的支持。大多数这样做的人,都找到了支持智商遗传力的证据。而卡明却只看到了证据中的瑕疵……以现有数据来看,倘若作者以同等的热情去评估「这些处理毫无影响」的原假设,他恐怕会发现自己根本无法不拒绝它。

7 反向链接

略

8 相似链接

略

9 参考文献

略

Thoughts Memo 汉化组译制

感谢主要译者 gemini-2.5-pro、校对 Jarrett Ye

原文:How Should We Critique Research? · Gwern.net

作者:Gwern Branwen